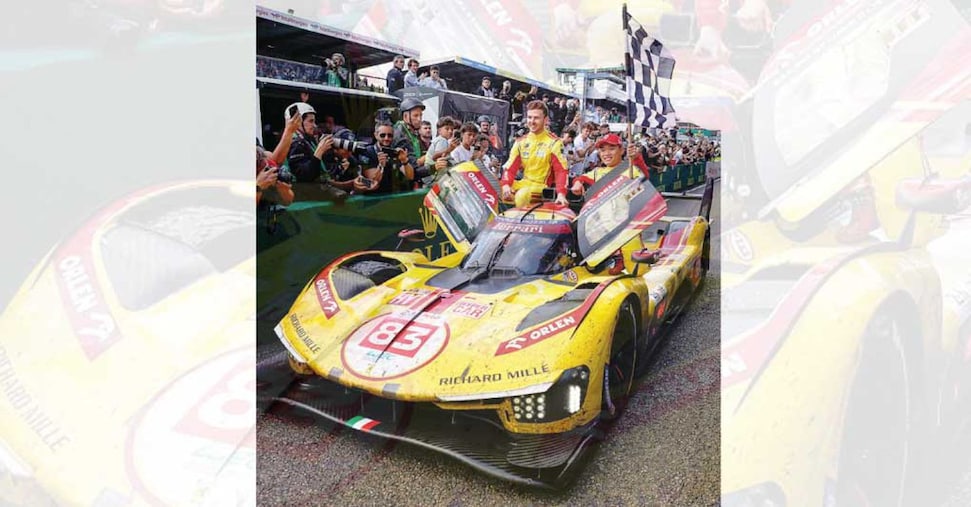

I portavoce della casa di Redmond l’hanno battezzato così: un nuovo acceleratore progettato per rendere l’intelligenza artificiale più veloce, più efficiente e più conveniente nell’uso di tutti i giorni. Annunciando Maia 200, Microsoft lancia un segno chiaro al mercato, promettendo a chiare lettere maggiore prestazioni per quanto riguarda l’inferenza (il processo di esecuzione di un modello di AI addestrato per fare previsioni su dati nuovi, e la velocità di implementazione a livello di datacenter e mettendo chiaramente nel mirino le TPU (Tensor Processor Unit) di Google e chip Trainium di Amazon. Scott Guthrie, Executive Vice President Cloud e AI di Microsoft, ha spiegato in un lungo blog post come Maia nasca per “migliorare drasticamente l’economia della generazione di token AI”, ribadendo come questa soluzione sia un passaggio chiave per rendere l’intelligenza artificiale non solo più avanzata ma anche più facilmente applicabile a casi e scenari reali e di vita quotidiana. Maia, in altre parole, vuole essere un “boost” del processo che permette all’AI di rispondere a prompt, generare contenuti o supportare decisioni in tempo reale) e un ulteriore segnale che la vera partita vera su questa tecnologia si gioca sulle piattaforme di silicio, e quindi sul piano dell’infrastruttura che consente ai modelli di funzionare su larga scala e a costi sostenibili.

Microsoft ha puntato espressamente sul fattore inferenza dell’inferenza ed evitato “scomodi” confronti con Nvidia perché il predominio della società di Jensen Huang nell’ambito del training è indiscutibile.