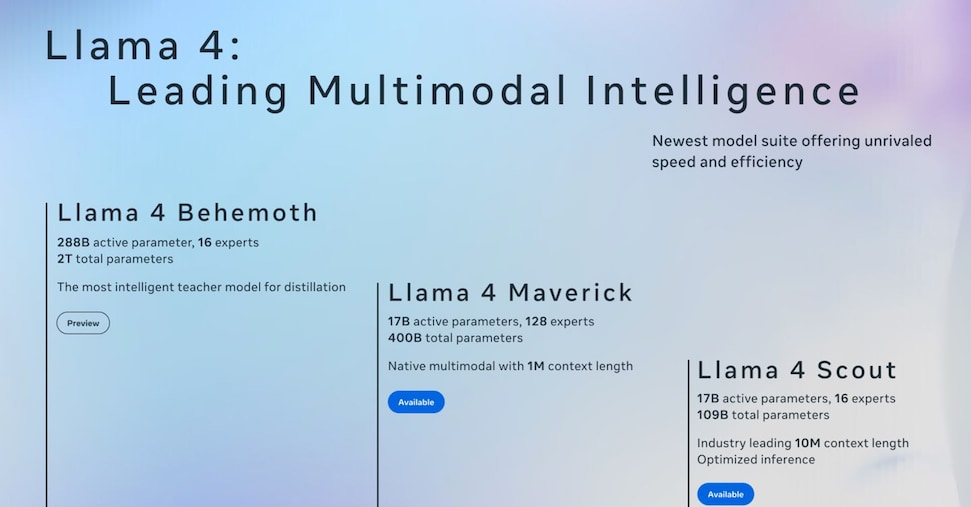

E poi c’è Llama 4 Maverick pensato come assistente generale e per la scrittura creativa. Della stessa taglia del suo fratello minore con 128 esperti e un totale di 400 miliardi di parametri, è il miglior modello multimodale della sua categoria sorpassando GPT-4o e Gemini 2.0 Flash in un’ampia gamma di benchmark, ottenendo risultati comparabili a DeepSeek v3 su ragionamento e codifica, con meno della metà dei parametri attivi.

In aggiunta, per i nuovi modelli, Meta afferma adottare a un’architettura MoE (mixture of experts) ovvero un approccio che punta a risparmiare risorse utilizzando solo le parti del modello che sono necessarie per svolgere un determinato compito suddiviso in task minori: “Stiamo introducendo Llama 4 Scout e Llama 4 Maverick, i primi modelli multimodali nativi open-weight con un supporto di lunghezza del contesto senza precedenti e il nostro primo costruito utilizzando un’architettura mixed-of-experts (MoE). Stiamo anche presentando in anteprima Llama 4 Behemoth, uno degli LLM più intelligenti al mondo e il nostro più potente finora a fungere da insegnante per i nostri nuovi modelli” scrive il team di Meta nel blogpost dell’annuncio ufficiale.

Llama 4 Behemoth, infatti, è un modello multimodale ancora in fase di addestramento che, con 288 miliardi di parametri attivi, 16 esperti e quasi due trilioni di parametri totali, fungerà da “docente” per i modelli Llama 4 più piccoli garantendo prestazioni di alto livello superiori a GPT-4.5, Claude Sonnet 3.7 e Gemini 2.0 Pro secondo diversi benchmark STEM.